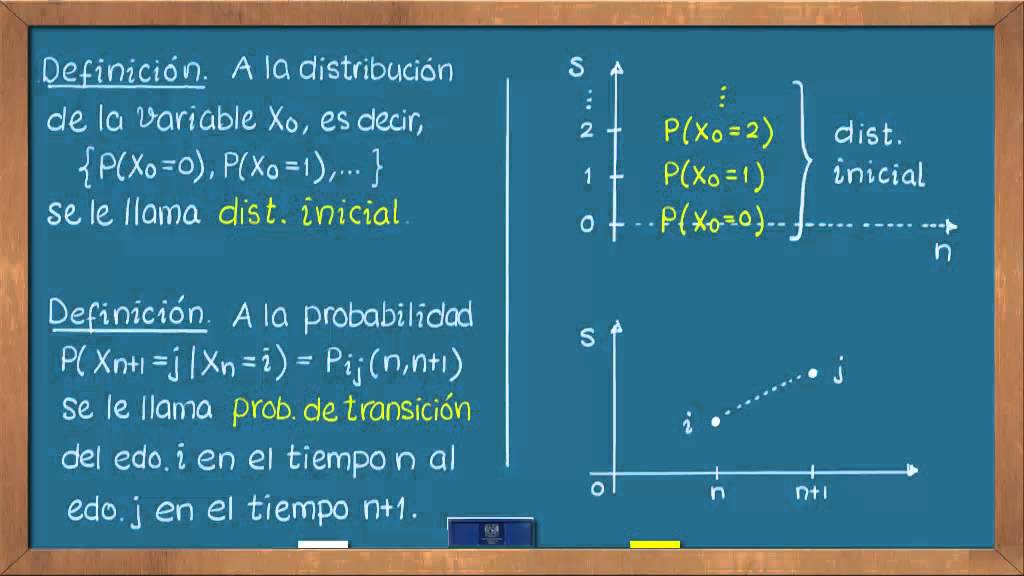

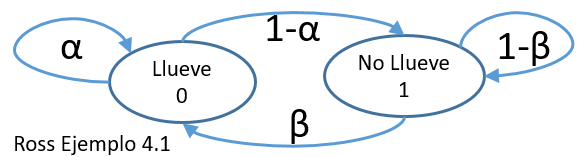

Introducción a la utilización de los modelos de Markov en el análisis farmacoeconómico | Farmacia Hospitalaria

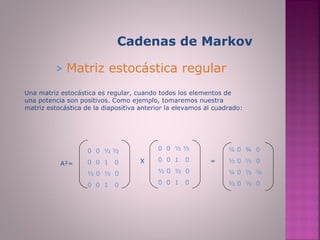

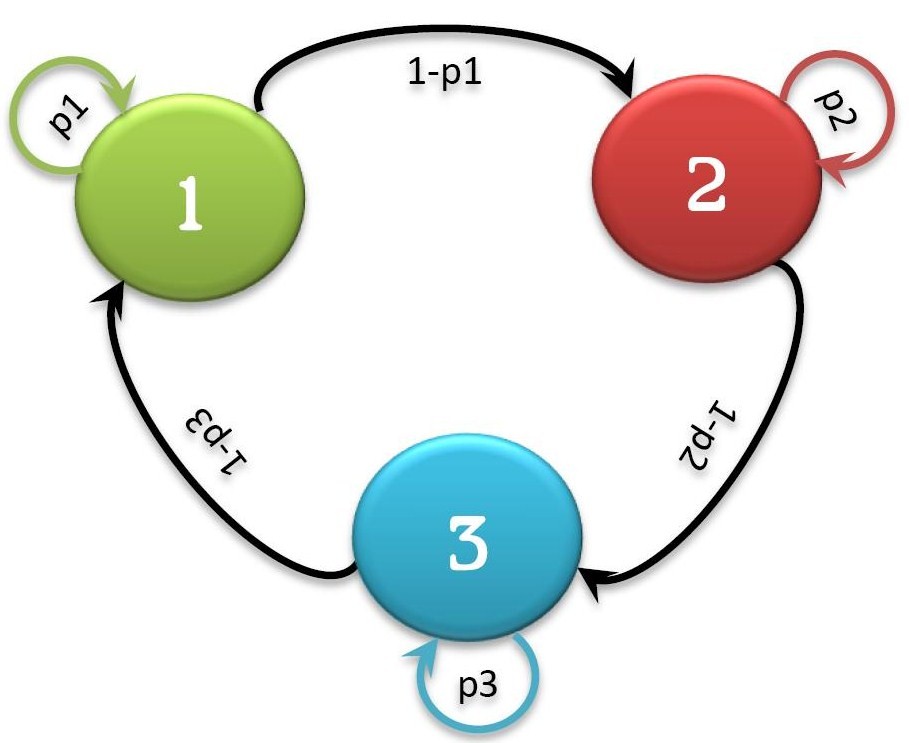

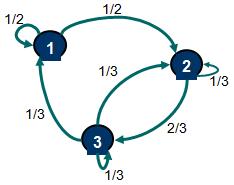

Clasificación de estados de una Cadena de Markov - Definición de cadena irreducible, estados recurrentes, transcientes, periódicos y aperiódicos

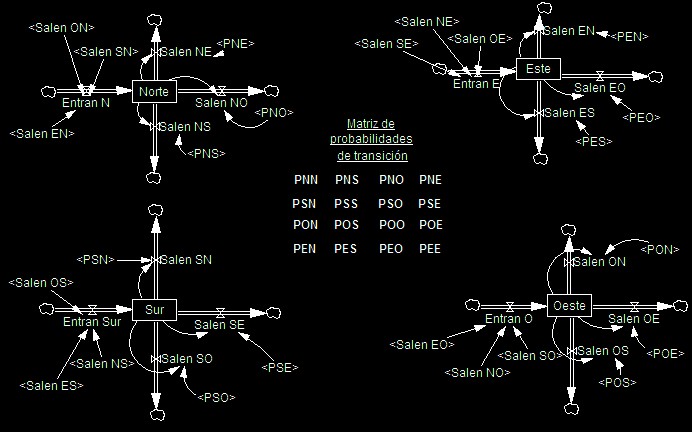

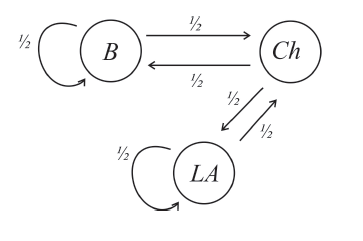

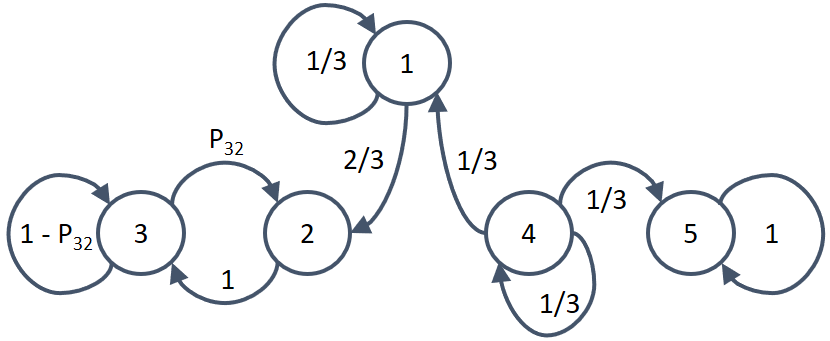

MUNDO IO - Investigación de Operaciones - En una Cadena de Markov es importante definir los estados que la componen, para luego elaborar un modelo y la matriz de transición. Los estados